Geleceğin Altyapısı: Yapay Zekâ İçin Özel Sunucu Çipleri

Geleceğin Altyapısı: Yapay Zekâ İçin Özel Sunucu Çipleri

Yapay zekâ (YZ) uygulamaları, son yıllarda inanılmaz bir hızla gelişti. Derin öğrenme modellerinin büyüklüğü ve karmaşıklığı arttıkça, onları hızlı bir şekilde eğitmek ve gerçek zamanlı çıkarım yapmak için gereken işlem gücü de katlanarak büyüdü. Geleneksel sunucu mimarileri; genel amaçlı CPU’lar veya tek tip GPU’lar bazen bu görevlerin altında eziliyor. İşte tam da bu nedenle, “Yapay Zekâ İçin Özel Sunucu Çipleri” kavramı doğdu. Bu yazıda, özel AI hızlandırıcı çiplerinin neden kritik olduğunu, nasıl çalıştığını, önde gelen örneklerini ve geleceğe dair beklentileri detaylı biçimde inceleyeceğiz.

1. Neden Özel Çip? Genel Amaçlı İşlemcilerin Sınırları

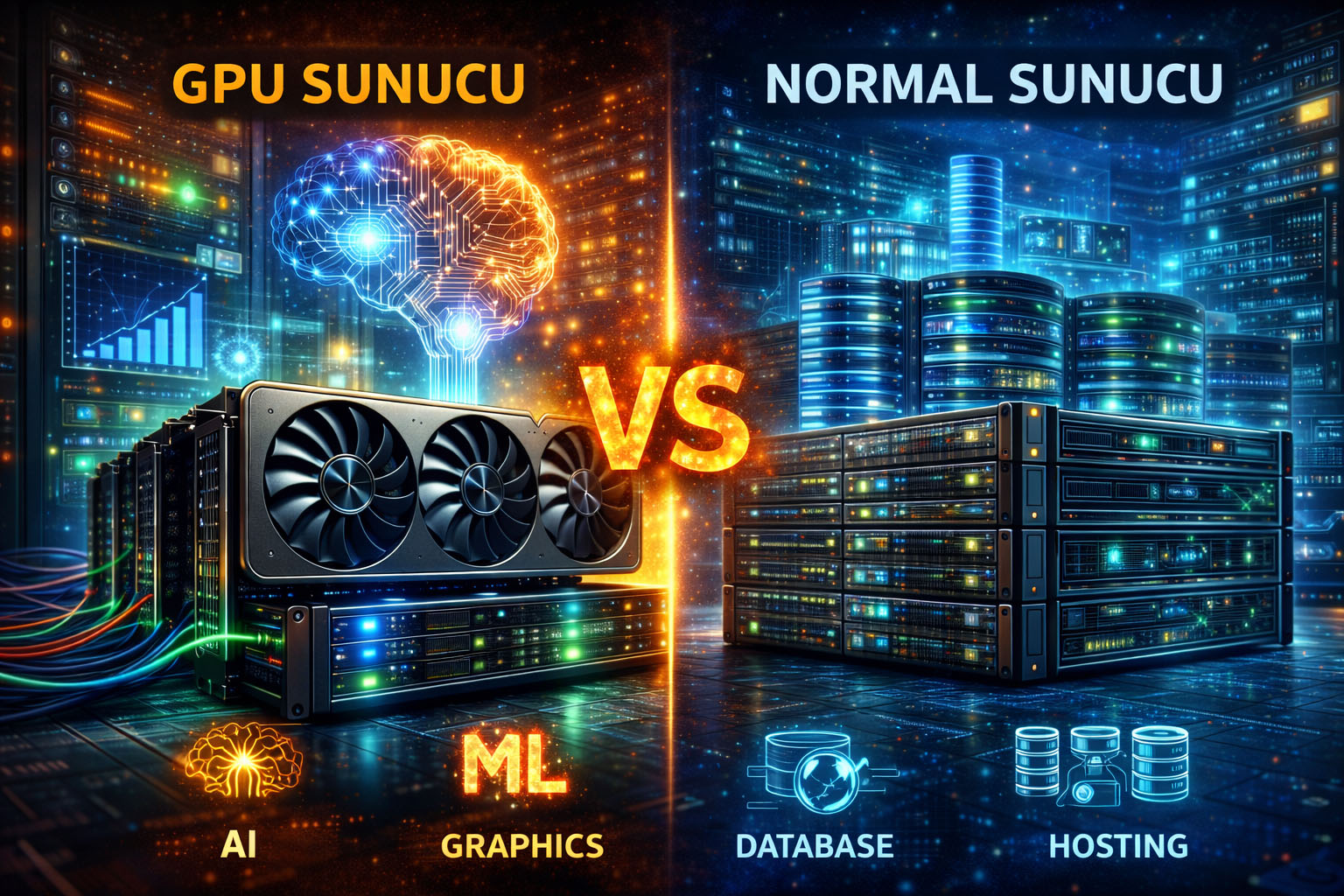

Geleneksel veri merkezi sunucularında, işlem yüklerinin büyük kısmı x86 tabanlı CPU’lar veya GPU’lar tarafından karşılanır. CPU’lar; esnek, çok yönlü ve yazılım ekosistemi açısından zengindir. Ancak derin öğrenme eğitimleri için gereken matris çarpımları ve büyük veri transferleri, CPU mimarisinin paralel işlem altyapısını verimli şekilde kullanmasını zorlaştırır. GPU’lar bu noktada daha iyi bir alternatif sunar; binlerce çekirdek sayesinde paralel hesaplarda üstün performans sağlarlar. Fakat GPU’lar da yapay zekâ dışındaki iş yüklerinde gereksiz güç tüketimine ve maliyete neden olabilir.

Özel AI hızlandırıcı çipleri (ASIC, NPU vb.), tam olarak YZ modellerinin ihtiyaç duyduğu matris ve tensör işlemlerini donanım düzeyinde optimize eder. Sonuç olarak:

- Performans: CPU/GPU’a kıyasla 5–50 kat arası daha yüksek çıkarım ve eğitim hızı

- Enerji Verimliliği: Watt başına daha fazla işlem, veri merkezi sıcaklık ve soğutma maliyetlerini düşürür

- Küçük Gecikme: Gerçek zamanlı uygulamalarda milisaniye düzeyinde yanıt süreleri

- Maliyet: Uzun vadede toplam sahip olma maliyeti (TCO) azalır

Bu avantajlar, büyük yapay zekâ modellerinin eğitimi, doğal dil işleme hizmetleri, görüntü ve video analizi ile otonom araç gibi gecikme sınırı sıkı uygulamalarda kritik öneme sahip.

2. Özel Çiplerin Temel Mimari Özellikleri

Bir AI hızlandırıcı çipi tasarlanırken başlıca şu bileşenler ele alınır:

- Matris İşleme Birimleri (MMU/Tensor Cores)

Derin öğrenme modelindeki matris ve tensör çarpımlarını donanım düzeyinde gerçekleştiren çekirdekler. Bu birimler, sabit- veya düşük hassasiyette (INT8, FP16, bfloat16) işlemleri yüksek paralellikte yapar. - Veri Havuzları ve Önbellek (On-chip Memory)

Model ağırlıklarını ve ara verileri düşük gecikmeyle erişmek için büyük ve hızlı SRAM blokları. Dış hafızaya sürekli erişim, gecikme ve enerji cezalarına yol açtığından, çoğu ağırlık ve özellik verisi çip içine taşınır. - Hafıza Bağlantıları (High-Bandwidth Memory, HBM)

Çip ile dış belleğin yüksek bant genişliği hatları (PCIe, NVLink veya yerleşik HBM yongaları). HBM4 veya DDR5/6 modüller, saniyede terabayt mertebesinde veri aktarım hızı sunar. - Programlanabilirlik ve Yazılım Desteği

Derin öğrenme framework’leri (TensorFlow, PyTorch, MXNet vb.) ile entegrasyon için derleyici katmanı, runtime kütüphaneleri ve optimizasyon paketleri. Kullanıcıların mevcut modellerini kolayca hızlandırıcıda çalıştırabilmesi için yazılım ekosistemi kritik önemdedir. - Enerji ve Termal Yönetim

Yüksek yoğunluktaki YZ çekirdekleri, ısı üretimini etkin şekilde kontrol etmek için çip içi gerilim/frekans ölçeklendirme (DVFS), güç adası tasarımları ve gelişmiş termal yollar kullanır.

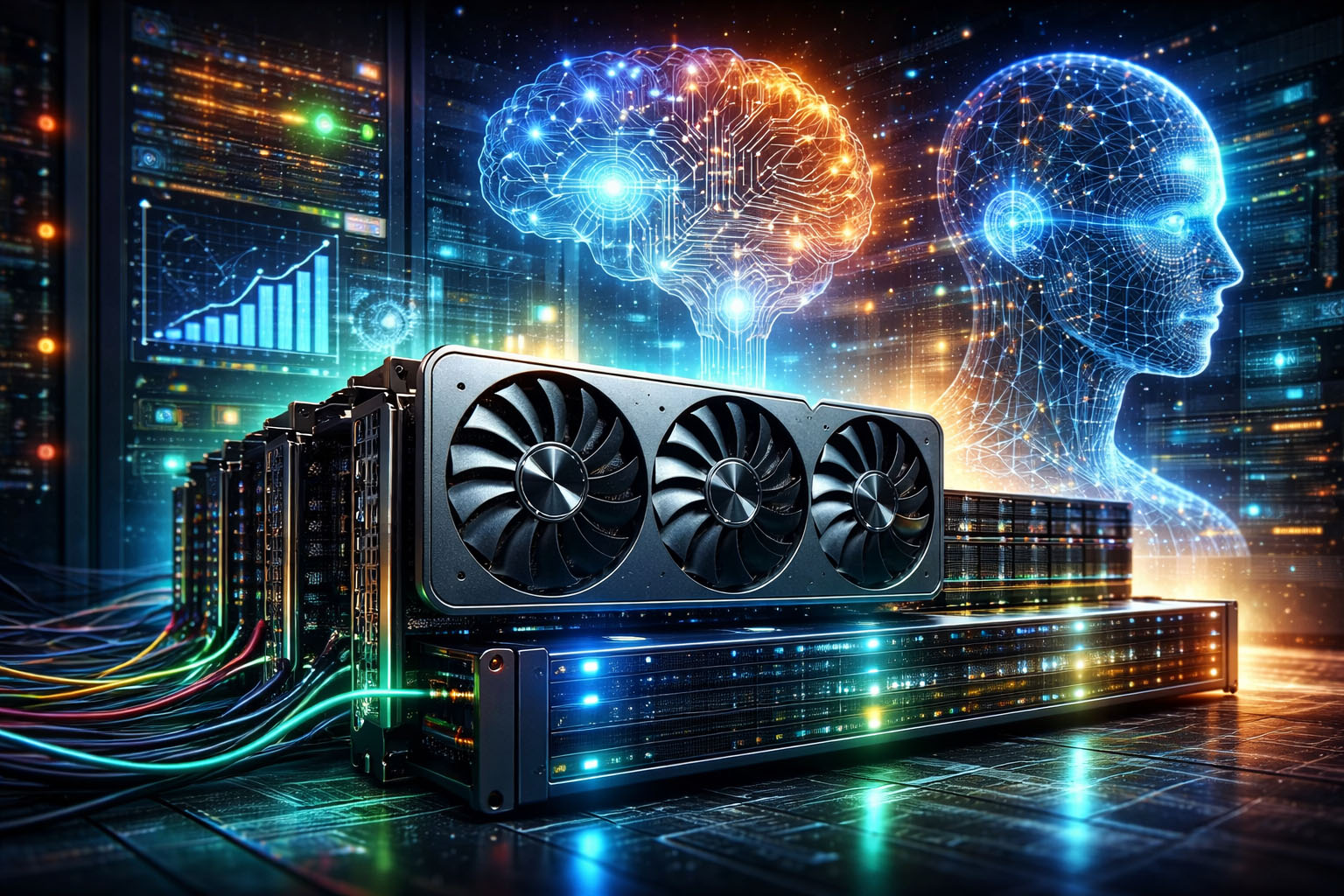

Bu bileşenler, AI iş yüklerini hem eğitim (training) hem de çıkarım (inference) aşamalarında yüksek verim ve düşük gecikme ile işleyebilmek amacıyla özel olarak şekillendirilir.

3. Piyasadaki Başlıca Örnekler

Günümüzde öne çıkan bazı özel AI sunucu çipleri ve hızlandırıcılar şunlardır:

a) NVIDIA Tensor Core GPU’ları

- H100 & Ada Lovelace Serisi: Her GPU’da yüzlerce tensor çekirdeği, 4. nesil NVLink ve HBM3 bellek

- Kullanım Alanı: Büyük dil modelleri (LLM), görüntü işleme, HPC simülasyonları

b) Google TPU (Tensor Processing Unit)

- TPU v4: 2 petaFLOPS eğitim hızı, model-paralelliğe özel tasarım

- Bulut Hizmeti: Google Cloud üzerinden TPU VM ve pod’lar olarak sunulur

c) AWS Inferentia & Trainium

- Inferentia: Yüksek performanslı inference için optimize edilmiş, düşük gecikme

- Trainium: Eğitim odaklı, yalıtılmış bellek havuzları ve ölçeklenebilir küme desteği

d) Apple “Baltra” Projesi

- 3 nm TSMC Süreci: Genişletilmiş Neural Engine çekirdekleri

- Amaç: Apple Intelligence’in bulut tarafında ölçeklenebilir altyapı

e) Graphcore IPU’ları

- Intelligence Processing Unit: Her bir IPU’da binlerce küçük paralel çekirdek, matris ağırlıklı veri akışına odaklı grafik işleme

f) Cerebras Wafer-Scale Engine

- Tek Devasa Çip: 850.000 mm²’lik bir çip; bellek ve işlem birimleri tek kalıpta

- Avantaj: Model ağırlıklarının tamamını on-chip saklayarak gecikmeyi asgariye indirir

g) Intel Gaudi ve Habana Labs Çözümleri

- Gaudi: Compute Express Link (CXL) desteği, RDMA üzerinden ölçeklenebilir bellek paylaşımı

- Habana Goya: Veri merkezleri için optimize inference hızlandırıcı

Her bir çözüm, eğitim ve çıkarım iş yüklerine göre farklı avantajlar sunar. Seçim yaparken iş yükü profili, toplam maliyet, enerji verimliliği ve yazılım uyumluluğu dikkate alınmalıdır.

4. Performans ve Verimlilik Ölçütleri

AI hızlandırıcılarını karşılaştırmak için kullanılan başlıca metrikler:

- Toplam FLOPS (Floating-Point Operations Per Second): Ham işlem gücünü gösterir.

- TOPs/Watt: Enerji verimliliğini ölçer; düşen enerji maliyeti ve soğutma ihtiyacı için kritik.

- Gecikme (Latency): İnference senaryolarında tek bir örneğin işlenme süresi.

- Bant Genişliği (Memory Bandwidth): Model ağırlıklarının hızla taşınabilmesi için gereklidir.

- Küme Ölçeklenebilirliği: Birden fazla hızlandırıcının bir arada kullanım verimliliği ve ağ bağlanırlığı (NVLink, InfiniBand).

Bu ölçütler, yalnızca çip tasarımının gücünü değil; aynı zamanda bellek hiyerarşisinin, yazılım yığınlarının ve sistem entegrasyonunun başarısını da gösterir.

5. Entegrasyon: Veri Merkezi ve Bulut Altyapısına Uyarlama

Yeni nesil AI çipleri, tek bir sunucuya takılı bir hızlandırıcıdan ibaret değildir. Entegrasyon şu aşamaları içerir:

- Rack ve Soğutma Tasarımı

Yüksek performanslı AI sunucuları, artan ısı yükü nedeniyle özel raf soğutma sistemleri veya immersion cooling dolu kabinler gerektirebilir. - Güç Dağıtımı

Her bir hızlandırıcı modülü, yüksek güç talebi doğurur. Yedekli güç kaynakları ve PDU’lar (Power Distribution Units) kritik önemdedir. - Ağ Bağlantısı

Düşük gecikmeli RDMA, InfiniBand veya NVLink topolojileri, hızlandırıcılar arasındaki veri alışverişini optimize eder. - Yazılım ve Orkestrasyon

Kubernetes, Slurm ya da AWS Batch gibi sistemlerle hızlandırıcılar otomatik olarak tahsis edilir; TensorFlow, PyTorch eklentileri, hızlandırıcılar üzerinde çalışacak iş yüklerini doğru biçimde yönlendirir. - Güvenlik

AI modellerinin ve eğitim verilerinin gizliliği için şifreleme, donanımsal güvenlik modülleri (Intel SGX veya özel şifreleme birimleri) kullanılır.

Doğru entegrasyon, yalnızca çip performansını değil; tüm veri merkezi verimliliğini de belirler.

6. Uygulama Senaryoları ve Başarı Hikâyeleri

- Doğal Dil İşleme (NLP): LLM’ler (ChatGPT, PaLM) gibi modeller, trilyonlarca parametre içeriyor. TPU-pod’lar veya Cerebras WSE, bu devasa eğitimleri günler yerine saatler içinde tamamlayabilir.

- Gerçek Zamanlı Görüntü Analizi: Otonom araçlar ve video gözetim sistemleri, düşük gecikmeli inference gerektirir. AWS Inferentia veya Apple’ın bulut AI altyapısı, milisaniye düzeyinde yanıt verebilir.

- Sağlık ve Genomik: Genetik dizileme verileri, yüksek bant genişliği ve paralel matris hesapları ister. Graphcore IPU’lar, genoma yönelik özel algoritmaları hızlandırır.

- Finansal Modelleme ve Simülasyon: Risk analizi, algoritmik ticaret ve portföy optimizasyonu için hızlı eğitim ve inference; NVIDIA Hopper GPU’lar ve Habana hızlandırıcılar yaygın olarak kullanılıyor.

Bu örnekler, özel AI sunucu çiplerinin gerçek dünya problemlerinde nasıl somut fayda sağladığını gösteriyor.

7. Geleceğe Bakış: 2 nm Çip Süreçleri ve Ötesi

Çip üretim teknolojileri 3 nm’ye inerken, önümüzdeki yıllarda 2 nm ve altı sürece geçiş planlanıyor. Bu sayede:

- Artan Transistör Yoğunluğu: Daha fazla matris çekirdeği, daha büyük on-chip önbellek

- Düşük Güç Tüketimi: Voltaj düşürme ve yeni malzeme kullanımlarıyla verimlilik artışı

- Entegre Soğutma Katmanları: Çip içine gömülü mikro akışkan yollar, ısıyı doğrudan taşır

Ayrıca Quantum-hibrit mimariler, klasik AI hızlandırıcılarla birlikte deneysel kuantum işlem ünitelerini veri ön işleme veya optimizasyon adımlarında kullanmayı vadediyor.

8. Karşılaşılan Zorluklar ve Çözüm Önerileri

- Yazılım Uyumluluğu: Farklı hızlandırıcılara destek veren derleyiciler ve runtime’lar hala gelişiyor. Çözüm: Taşınabilir derleyici projeleri (ONNX, TVM) ve açık kaynak optimizasyon paketleri.

- Toplam Maliyet: İlk yatırım maliyeti yüksek olabilir. Çözüm: Bulut altyapısında kiralama modeliyle TCO’yu düşürmek ve kullanım bazlı faturalama.

- Soğutma ve Altyapı Güncellemesi: Mevcut raflar yeni soğutma sistemlerine hazır olmayabilir. Çözüm: Aşamalı yatırım planları ve pilot kabin uygulamaları.

- Güvenlik ve Veri Mahremiyeti: Model çalınması veya verinin sızması riskleri. Çözüm: Donanım tabanlı şifreleme, izinsiz erişim tespiti ve secure enclave teknolojileri.

Bu zorlukları aşmak, doğru planlama, pilot uygulamalar ve yazılım-hardware ortak geliştirme süreçleri gerektirir.

9. Sonuç ve Öneriler

Yapay zekâ için özel sunucu çipleri, günümüzün en yoğun işlem gücü taleplerini karşılamak üzere tasarlanmış, yüksek paralellik ve enerji verimliliği sunan kritik altyapı bileşenleridir. Başarılı bir AI stratejisi için:

- İş Yükü Analizi: Eğitim mi, çıkarım mı yoksa her ikisi mi? Hangi model büyüklüklerine odaklanacaksınız?

- Donanım Seçimi: Performans ve verimlilik kriterlerine göre uygun hızlandırıcıyı belirleyin.

- Altyapı Entegrasyonu: Soğutma, güç dağıtımı, ağ mimarisi ve yazılım yığınını uyumlu hale getirin.

- Pilot ve Ölçek: Önce küçük çaplı bir test ortamında deneyin, ardından aşamalı olarak üretime geçirin.

- Sürekli İyileştirme: Yeni çip süreçleri, yazılım güncellemeleri ve otomasyon araçlarıyla verimliliğinizi düzenli olarak güncelleyin.

Özel AI hızlandırıcı çiplerine yatırım yapmak, hem performans hem de maliyet açısından uzun vadeli rekabet avantajı sağlar. Geleceğin yapay zekâ altyapısı, bu özelleştirilmiş donanımlar sayesinde çok daha hızlı, verimli ve esnek bir biçimde şekillenecektir.