Yapay Zeka Çağını Şekillendiren Yeni Nesil Sunucular

Yapay Zeka Çağını Şekillendiren Yeni Nesil Sunucular

Bilgi işlem dünyası, yapay zekâ (YZ) iş yüklerinin karmaşıklığı ve hacmindeki hızlı artışla birlikte köklü bir dönüşüm yaşıyor. Geleneksel sunucu mimarileri—özellikle x86 tabanlı CPU merkezli veri merkezleri—artık tek başlarına derin öğrenme eğitimleri, gerçek zamanlı çıkarım süreçleri ve büyük veri analitiği taleplerini karşılamada yetersiz kalıyor. Bu ihtiyaçları karşılamak için geliştirilmiş “yeni nesil sunucular”, donanım ve yazılım bileşenlerini baştan aşağı yeniden ele alarak yüksek paralellik, düşük gecikme, enerji verimliliği ve ölçeklenebilirlik gibi kritik gereksinimleri bir arada sunuyor. Bu yazıda, YZ odaklı iş yüklerinin ihtiyaçlarına cevap veren en öne çıkan teknoloji trendlerini, uygulama senaryolarını, avantajlarını ve gelecek perspektiflerini detaylı şekilde ele alacağız.

1. Donanımda Dikey Bütünleşme: ARM, ASIC ve NPU’lar

Son yıllarda ARM tabanlı mimariler, veri merkezlerinde x86’ya ciddi bir alternatif oluşturuyor. ARM sunucular, watt başına sunduğu yüksek verim ve düşük ısı üretimi avantajlarıyla makine öğrenimi çıkarım iş yüklerinde öne çıkıyor. Amazon Graviton4, Google Axion ve NVIDIA Grace CPU gibi örnekler, bulut sağlayıcılarının hem maliyet hem de performans tarafında tercih ettiği çözümler arasında. ARM çekirdekleri, ölçeklenebilir paralel işlem yetenekleri sayesinde, özellikle token bazlı çıkarım (inference) süreçlerinde x86 tabanlı sunuculara göre %30–%40 daha az enerji harcayabiliyor.

Bunun yanı sıra ASIC (Application-Specific Integrated Circuit) ve NPU (Neural Processing Unit) hızlandırıcılar, amaçlarına özel donanımla derin öğrenme eğitim ve çıkarım süreçlerini CPU/GPU kombinasyonlarına kıyasla on katı aşan verimlilikle çalıştırabiliyor. Google’un TPU serisi, Amazon Inferentia, Apple’ın Baltra projesi veya Intel’in Gaudi hızlandırıcıları gibi ASIC tabanlı çözümler, sinir ağı matris çarpımlarını donanım seviyesinde optimize ederek eğitim sürelerini günlerden saatlere indirmeyi başarıyor.

Donanımda tam dikey bütünleşme, bu farklı çip mimarilerini tek bir platformda birleştirmeyi de içeriyor. Örneğin bazı sunucu üreticileri, CPU, GPU ve NPU birimlerini bir arada bulunduran hibrit XPU kartları sunmaya başladı. Böylece AI iş yükü, en uygun çekirdek türünde dinamik olarak çalıştırılabiliyor; örneğin çıkarım iş yüklerinde NPU’lar, eğitimde ise GPU’lar devreye giriyor. Bu sayede enerji verimliliği ve performans arasında optimum denge kuruluyor.

2. Kompozable ve Disaggregated Altyapılar

Yeni nesil sunucu mimarilerinin en dikkat çekici yeniliği, fiziksel donanım kaynaklarını esnek havuzlar halinde sunabilmeleri. Compute Express Link (CXL) ve PCIe Gen5/6 destekli sunucular, CPU, bellek ve hızlandırıcı kartları yüksek bant genişlikli, düşük gecikmeli veri yollarıyla birbirine bağlayarak “donanım parçalarını sanal sunucu” tanımlarıyla birleştirmeye izin veriyor. Bu yapı, uygulamaya özel sunucu oluşturmak için saniyeler içinde bileşenleri dinamik olarak atama imkânı tanıyor.

Örneğin büyük bir dil modeli eğitimi için yüksek miktarda bellek ve düşük gecikmeli hafıza erişimi gerekliyken; başka bir finansal analiz uygulaması, daha çok CPU çekirdeği ve NVMe depolama performansı talep ediyor. Kompozable altyapı sayesinde, bu kaynak setleri ayrı fiziksel sunucular yerine tek bir soyut havuzdan çekilip anlık olarak kullanılıyor. Böylece kaynak israfı azalıyor, veri merkezi verimliliği artıyor ve bakım faaliyetleri kolaylaşıyor.

Buna paralel olarak “disaggregated” mimariler, sunucu raflarının ayrıştırılmış depolama ve bellek modülleriyle donatılmasını ifade ediyor. Rack düzeyinde ortak depolama havuzları ve bellek modülleri, birden fazla sunucunun ihtiyaç duyduğu anda kullanımına açılıyor. Sonuç; esnek ölçeklenebilirlik, daha hızlı arıza tespiti ve onarım, ayrıca uzun vadede maliyet etkinliği.

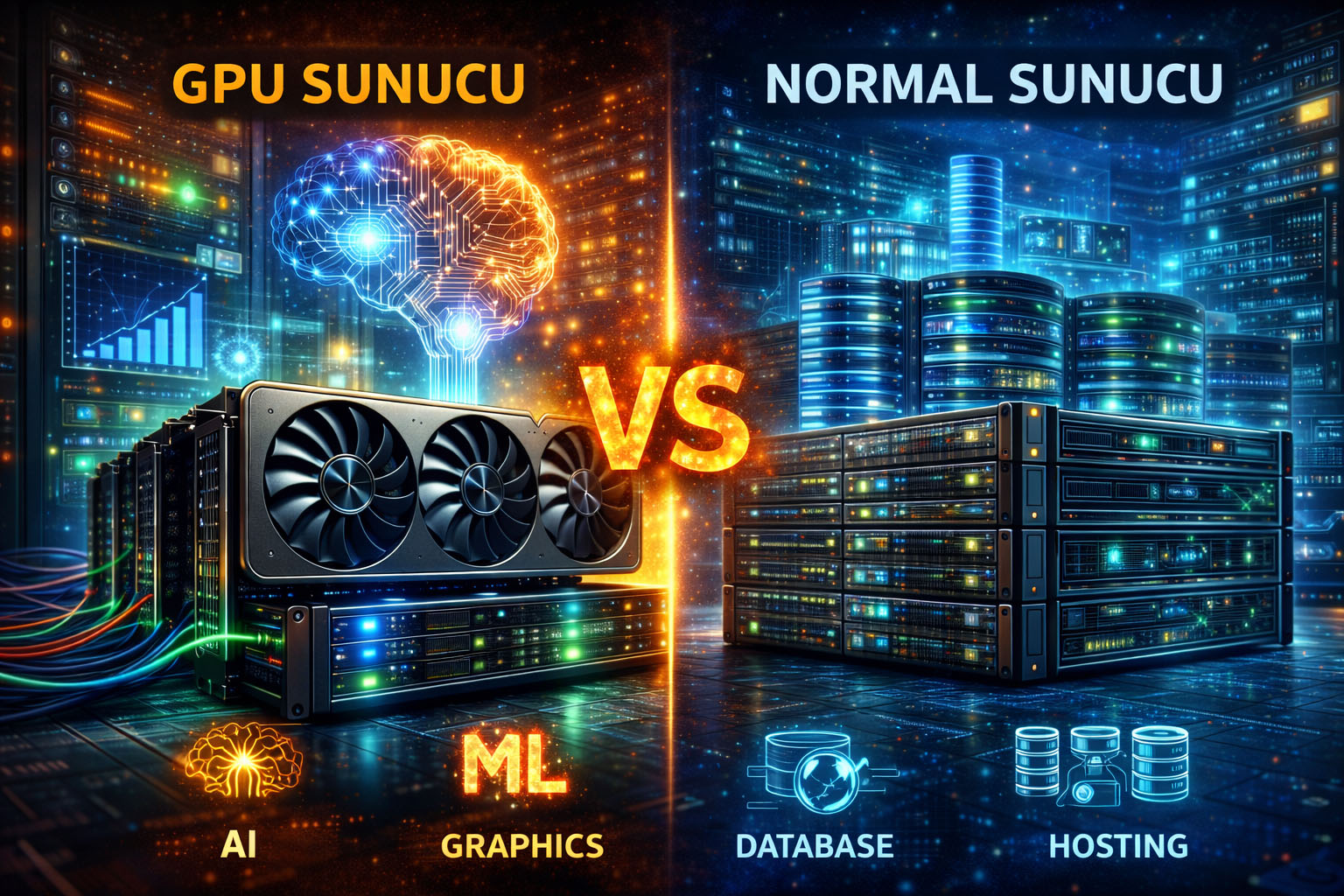

3. GPU ve XPU Entegrasyonu

Derin öğrenme modelinin eğitimi söz konusu olduğunda GPU hâlâ pazarın lideri konumunda. NVIDIA’nın Hopper, Ada Lovelace ve H100 gibi serileri, yüksek bant genişliği bellek (HBM3), Tensor çekirdekleri ve optimizasyonlarla petabayt ölçeğindeki veri kümelerini işleyebiliyor. Öte yandan eğitimden çıkarıma geçildiğinde, GPU’ların bir kısmı boşta kalabilir. İşte tam bu noktada hibrit XPU kartları devreye giriyor.

Hibrit XPU’lar; CPU, GPU ve NPU birimleri tek bir modülde toplayarak iş yüküne göre en uygun hızlandırıcıyı seçiyor. Örneğin çıkarım aşamasında veri modeli, GPU yerine enerji verimliliği daha yüksek NPU’ya aktarılabiliyor. Lenovo ThinkSystem veya Dell PowerEdge’in yeni nesil modellerinde, birden fazla hızlandırıcı aynı kabinde uyumlu biçimde çalışarak sunucu içi birleşik bir havuz oluşturuyor. Bu yaklaşım, hem maliyet hem de performans açısından esneklik sağlıyor, donanım kullanım oranını maksimize ediyor.

Ayrıca, üreticiler ASIC tabanlı hızlandırıcıları GPU ve CPU ile koordine eden özel yazılımlar geliştiriyor. Sıklıkla kullanılan AI framework’leri (TensorFlow, PyTorch) bu hızlandırıcı türlerini tanıyacak şekilde güncelleniyor; böylece geliştiriciler, altyapıda hangi donanım kaynaklarının kullanılacağını kod düzeyinde kolayca belirleyebiliyor.

4. Soğutma ve Enerji Verimliliği

Yoğun hesaplama gücü gerektiren donanımların ısınma problemi, veri merkezi ölçekli altyapıların sürdürülebilirliği açısından kritik bir konu. Yeni nesil sunucular, geleneksel fan tabanlı soğutmanın ötesine geçerek sıvı soğutma çözümlerini yaygınlaştırıyor.

Doğrudan sıvı daldırmalı (liquid immersion) soğutma yöntemi, sunucu bileşenlerinin dielektrik özellikli sıvılar içine doğrudan batırılmasını içeriyor. Bu sıvılar, ısıyı hava soğutmaya kıyasla 2–3 kat daha hızlı dağıtıyor. Böylece işlemciler ve hızlandırıcılar tam kapasitelerinde çalışırken bile termal darboğazlar ortadan kalkıyor, sunucuların performans reglajı (throttling) yapması engelleniyor.

Raf düzeyinde sıvı soğutma ise data center raflarının yan duvarlarına entegre edilen sıvı boru hatlarıyla gerçekleştiriliyor. Rack’ten geçen soğutucu akışkan, tüm sunucuların kritik bileşenlerini homojen biçimde soğutuyor. Bu yöntem PUE (Power Usage Effectiveness) değerlerini 1.1’in altına çekmeye yardımcı oluyor; yani her 1 kW’lık BT yükü için yalnızca 0.1 kW ek enerji soğutmaya harcanıyor.

Bunlara ek olarak, watt başına iş (performance per watt) metriği YZ iş yüklerinin farklı senaryolar için optimize edildiği yeni işlemci ve hızlandırıcı tasarımlarıyla iyileştiriliyor. Düşük frekanslı verimli çekirdekler, dinamik frekans ve voltaj ayarlamaları (DVFS) ile özellikle çıkarım iş yüklerinde enerji tüketimi yüzde 40’a kadar azaltılabiliyor.

5. NVMe-oF ile Yüksek Performanslı Depolama

Yapay zekâ projelerinde veri büyüklüğü petabaytları bulabiliyor. Bu kadar büyük veri kümelerinin eğitim ve çıkarım süreçlerinde hızlı okunup yazılması, sunucu performansının en kritik unsurlarından biri. Geleneksel SAS/SATA çözümlerinin yerini NVMe SSD’ler aldı; PCIe 4.0, 5.0 ve yakında 6.0 destekli NVMe sürücüler, saniyede milyonlarca I/O işlemi gerçekleştirebiliyor.

Ancak NVMe SSD’lerin tam potansiyeli, NVMe-over-Fabrics (NVMe-oF) protokolleriyle açığa çıkıyor. Ethernet veya RDMA tabanlı NVMe-oF, yüksek bant genişlikli depolama ağı üzerinden sunucu havuzlarına doğrudan birbirine bağlı diskler gibi davranma imkânı veriyor. Depolama gecikmesi, SAS ortamına kıyasla %70’e varan oranda düşüyor, eğitim kümeleri tek bir fiziksel sunucunun sınırlarını aşarak GPU kümesi genelinde yayılabiliyor.

Birçok bulut sağlayıcısı ve büyük ölçekli kurum, NVMe-oF altyapılarına geçiş yaparak veri merkezi içindeki depolama darboğazlarını ortadan kaldırıyor. Bu sayede GPU kümeleri sürekli tam doluluk oranıyla, bekleme (stall) süresi minimuma inerek çalışabiliyor. Depolama ve işlem katmanlarının sıkı entegrasyonu, YZ modellerinin eğitim süresini günlerden saatlere indiriyor.

6. Uç Bilişim ve Sunucu Tabanlı AI

İnternet’e bağlı milyarlarca cihazdan akan veri, santralize veri merkezlerine kadar gitmeden işlenirse gecikme süreleri milisaniyelere iniyor. Bu nedenle “edge sunucular”, yani uç bilişim amacıyla tasarlanmış yeni nesil cihazlar öne çıkıyor. Fabrika otomasyonu, akıllı şehir sensör ağları ve otonom araç kontrol sistemleri gibi senaryolarda, verinin anlık işlenmesi kritik önem taşıyor.

Edge sunucular genellikle modüler, rafa veya saha dolaplarına kolayca yerleşebilen kompakt kabinler olarak tasarlanıyor. İçlerinde ARM tabanlı CPU’lar, entegre NPU’lar ve yerel NVMe depolama birimleri bulunuyor. Gecikme kritik operasyonlar, bulut bağlantısı sağlanamasa dahi bu cihazlar üzerinde kesintisiz devam edebiliyor. Örneğin otonom araçlarda, araç içi sunucu gerçek zamanlı görüntü analizi yaparak saniyede yüzlerce frame’i işleyebiliyor.

Ayrıca bazı üreticiler, hava koşullarına dayanıklı, güneş enerjisi destekli edge data center kabinleri geliştiriyor. Bu kabinler, şehir merkezlerine veya uzak kırsal alanlara konuşlandırılarak bulut ve merkezî veri merkezi yükünü hafifletiyor, bant genişliği maliyetlerini azaltıyor.

7. Yazılım-Tanımlı Altyapı ve Otomasyon

Yeni nesil sunucularda donanım kadar yazılım da kritik bir rol oynuyor. Geleneksel “manuel konfigürasyon” yerine Infrastructure as Code (IaC) benimseniyor. Terraform, Ansible, Pulumi gibi araçlarla sunucu ağ yapısı, depolama ayarları ve işlem kaynakları sürüm kontrolü altında tanımlanıp otomatik olarak dağıtılabiliyor. Böylece yeni sunucu ortamları dakikalar içinde devreye alınabiliyor, insan kaynaklı hata riski azalıyor.

Software-Defined Networking (SDN) ile ağ topolojisi ve trafik optimizasyonu API’ler aracılığıyla programatik olarak yönetiliyor. AI iş yüklerinin yoğunlaştığı trafik noktalarına göre ağ katmanındaki yönlendirmeler gerçek zamanlı güncelleniyor. Örneğin büyük bir eğitim görevi başladığında, ilgili sunucu havuzuna ağ bant genişliği dinamik olarak artırılabiliyor.

Buna ek olarak, AI Operatörleri (Kubernetes Operators) geliştirilerek yapay zekâ modellerinin dağıtımı, ölçeklendirmesi ve bakım işlemleri otomatikleştiriliyor. Model versiyonlama, A/B testi ve geri dönüş (rollback) senaryoları kodla tanımlanıp izlenebiliyor. Bu sayede insan müdahalesine neredeyse hiç ihtiyaç kalmadan, kapalı devre bir sistemde güvenle operasyon yürütülüyor.

8. Güvenlik ve Sıfır Güven Mimarisi

YZ modelleri, genellikle hassas verilerle eğitildiğinden altyapıda güvenlik en üst düzeyde sağlanmalı. Yeni nesil sunucularda Zero Trust (sıfır güven) prensipleri benimseniyor: İç ağ içerisinde bile her bağlantı ve erişim isteği dinamik olarak doğrulanıyor, şifreleniyor ve en az ayrıcalık modeliyle yönetiliyor.

Donanımsal güvenlik modülleri—Intel SGX, AMD SEV, Arm TrustZone—işlemci seviyesinde bellek bölmelerinde şifreli ortam sunuyor. Böylece eğitim verisi veya model ağırlıkları, herhangi bir dış saldırıya veya içeriden gelebilecek tehditlere karşı korunmuş oluyor. Hatta bazı özel AI hızlandırıcı çipler, kendi şifreleme ve kimlik doğrulama donanımına sahip olarak, modelin bütün parametre setini dışarıya asla açmıyor.

Ayrıca ağ katmanında mikro segmentasyon, her sunucu ve uygulama bileşeninin birbirinden izole edilmesini sağlıyor. Güvenlik duvarı ve IDS/IPS sistemleri, gerçek zamanlı telemetri analiziyle anormal davranışları tespit ederek olası tehditleri otomatik olarak izole edebiliyor.

9. Sürdürülebilirlik ve Yeşil Veri Merkezleri

Büyük ölçekli YZ eğitim kümeleri, megavat mertebesinde enerji talebi yaratıyor. Bu yüzden yeni nesil veri merkezleri, çevresel etkiyi en aza indirmek için yenilenebilir enerji kaynakları, termal geri kazanım ve karbon nötrlüğü hedefleri etrafında şekilleniyor. Birçok tesis, güneş panelleriyle çatı üstü enerji üretimi yaparken, atık ısıyı soğutma döngüsüne geri vererek ek enerji tasarrufu sağlıyor.

Su bazlı soğutma sistemleri, verimliliği artırırken su tüketimini düşüren kapalı döngü tasarımlarına kavuştu. Bazı ileri tesisler, su yerine doğa dostu soğutkanlarla çalışarak hem verim hem de çevre uyumu sağlıyor. Ayrıca, veri merkezi yönetim yazılımları karbon ayak izini gerçek zamanlı izleyerek, yük dağılımını ve kaynak kullanımı planlamasını karbon hedeflerine göre optimize ediyor.

10. Gelecek Vaat Eden Trendler

- PCIe Gen6 ve CXL Gen3: Çift yönlü 256 GB/s bant genişliği ve geliştirilmiş bellek paylaşımı, sunucu içi bileşenler arasında darboğazları neredeyse tamamen kaldıracak.

- DDR6 ve HBM4: 12 Tbps’e yaklaşan hızlar ve gelişmiş hata düzeltme (ECC) kabiliyetleri, büyük dil modellerinin parametre setlerini tek adımda yüklemeyi mümkün kılacak.

- 2 nm ve Altı Çip Süreçleri: 2027’ye kadar 2 nm üretime geçildiğinde watt başına performansta %50’lere varan artışlar, enerji verimliliğinde de benzer kazanımlar sunacak.

- Quantum-Hibrit Mimari: Kuantum hızlandırıcıların klasik CPU/GPU/NPU altyapısıyla uyumlu şekilde çalıştığı deneysel prototipler, gelecekte YZ hesaplamalarında yeni bir çığır açabilir.

Sonuç

Yapay zekâ çağında sunucu altyapıları; dikey bütünleşme, kompozable mimariler, hızlandırıcı entegrasyonları, yazılım-tanımlı otomasyon, gelişmiş soğutma çözümleri ve sıfır güven yaklaşımlarıyla baş döndürücü bir hızla evriliyor. Bu yeni nesil sunucular, yalnızca performans artışı veya maliyet optimizasyonu sağlamıyor; aynı zamanda sürdürülebilirlik, güvenlik ve ölçeklenebilirlik açılarından da kurumlara uzun vadeli rekabet avantajı sunuyor. Kuruluşlar, YZ odaklı iş yüklerini doğru altyapı stratejisiyle destekleyerek hem teknoloji trendlerinin ön safında yer alabilir hem de kaynak kullanımını ve çevresel etkilerini en aza indirebilir. Geleceğin yapay zekâ uygulamaları, işte tam da bu “yeni nesil sunucular” sayesinde mümkün kılınacak.

Yorum gönder